ในยุคที่องค์กรขับเคลื่อนด้วยข้อมูล (Data-Driven Organization) การมีข้อมูลที่ ถูกต้อง ครบถ้วน และเชื่อถือได้ เป็นสิ่งสำคัญ เพราะข้อมูลที่มีคุณภาพต่ำอาจส่งผลต่อการตัดสินใจ ทำให้วิเคราะห์ผิดพลาด หรือเสียค่าใช้จ่ายในการแก้ไขภายหลัง

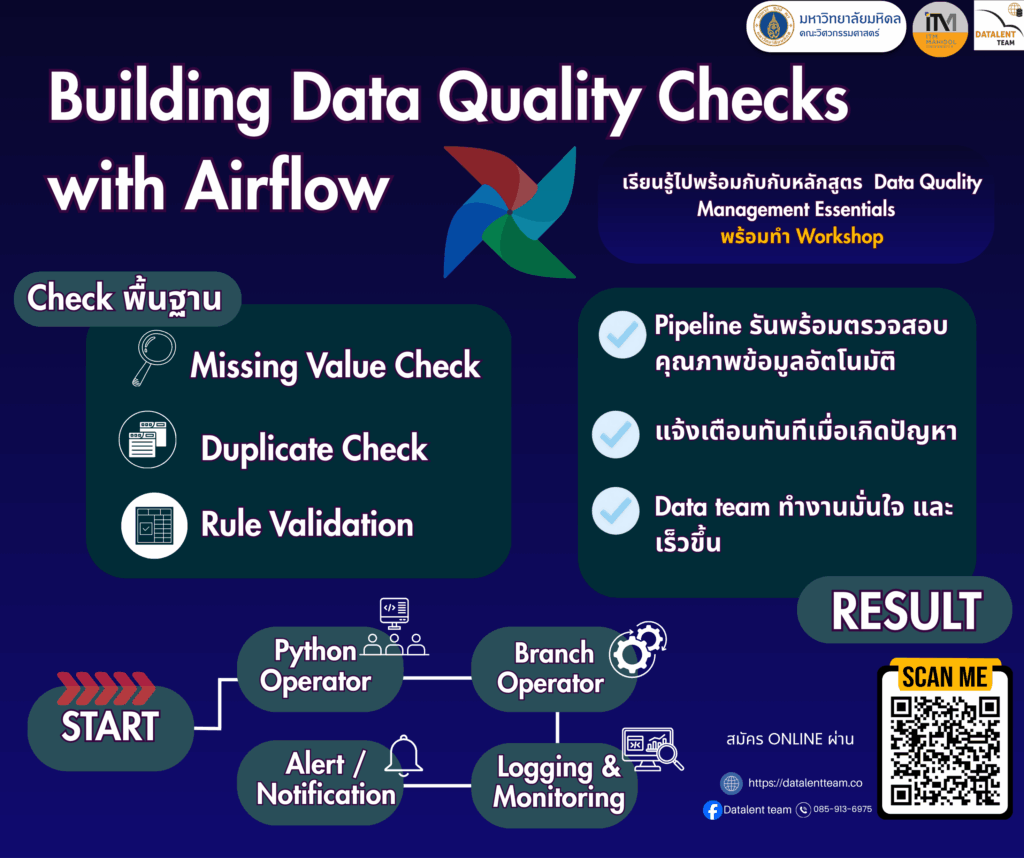

หนึ่งในเครื่องมือสำคัญในการดูแลคุณภาพข้อมูลคือ Data Quality Checks และเมื่อทำงานร่วมกับ Apache Airflow จะช่วยให้การตรวจสอบข้อมูลเป็นระบบ อัตโนมัติ และมีประสิทธิภาพมากขึ้นData Quality Checks คืออะไร

Data Quality Checks คือกระบวนการตรวจสอบว่าข้อมูลในระบบมีคุณภาพตามมาตรฐานที่องค์กรกำหนดหรือไม่

โดยทั่วไปจะตรวจสอบเรื่องต่าง ๆ เช่น:

- ค่าที่ขาดหาย (Missing Values): ข้อมูลสำคัญหายไปหรือไม่ เช่น ช่องว่างในตารางข้อมูล

- ข้อมูลซ้ำ (Duplicates): มีข้อมูลซ้ำซ้อนหรือไม่

- ค่าที่ไม่ถูกต้อง (Valid Range): ข้อมูลอยู่ในช่วงที่สมเหตุสมผลหรือไม่ เช่น อายุไม่ควรเป็นค่าลบ

- ความสัมพันธ์ระหว่างตาราง (Referential Integrity): ข้อมูลเชื่อมโยงระหว่างตารางยังถูกต้องอยู่ เช่น foreign key ต้องตรงกับ primary key

การตรวจสอบเหล่านี้ช่วยให้มั่นใจว่าข้อมูลที่นำไปใช้ในการวิเคราะห์หรือรายงานมีความน่าเชื่อถือ

ทำไมต้องใช้ Airflow มาช่วย

Apache Airflow เป็นเครื่องมือสำหรับจัดการ Data Pipeline หรือ Workflow ของข้อมูล จุดเด่นที่ทำให้ Airflow เหมาะกับงาน Data Quality Checks ได้แก่:

มีระบบบันทึกและแจ้งเตือน (Logging & Alerts): เมื่อข้อมูลไม่ผ่านเกณฑ์ คุณสามารถตั้งค่าให้ส่งอีเมลหรือแจ้งเตือนทีมงานทันที

ตั้งเวลาอัตโนมัติ (Scheduling): สามารถกำหนดให้ตรวจสอบข้อมูลเป็นประจำ เช่น ทุกวัน ทุกสัปดาห์ หรือทุกชั่วโมง

ควบคุมลำดับการทำงาน (DAG – Directed Acyclic Graph): กำหนดลำดับขั้นตอนการตรวจสอบได้ชัดเจน เช่น ตรวจสอบค่าที่ขาดหาย → ตรวจสอบค่าซ้ำ → ตรวจสอบช่วงค่า

นำ Workflow ไปใช้ซ้ำได้หลาย Pipeline: เขียนโค้ดตรวจสอบครั้งเดียว สามารถนำไปใช้กับหลายฐานข้อมูลหรือหลาย pipeline ได้

สรุป

การทำ Data Quality Checks เป็นสิ่งจำเป็นสำหรับทุกองค์กรที่ต้องการใช้ข้อมูลอย่างมีประสิทธิภาพ

เมื่อผสานกับ Airflow การตรวจสอบข้อมูลจะกลายเป็น อัตโนมัติ มีระบบ และตรวจสอบได้ต่อเนื่อง ช่วยลดความเสี่ยงจากข้อมูลผิดพลาด และสร้างความเชื่อมั่นในข้อมูลสำหรับการตัดสินใจขององค์กร

Post a comment